Ju

@ju@nugole.it

Parlo di un sacco di cose, per lo più in italiano, a volte in inglese.

Gli argomenti in genere sono: poesia, politica, gatti, storia, giardinaggio, uncinetto, montagne, informatica, fantasy, fantascienza, non necessariamente in quest'ordine: va un po' a periodi.

L'account è privato: le eventuali richieste di seguirmi sono soggette ad approvazione, l'approvazione non è automatica e non è garantita.

Questa istanza blocca i social network commerciali (Threads).

🏳️🌈 🇪🇺 🇺🇦

===

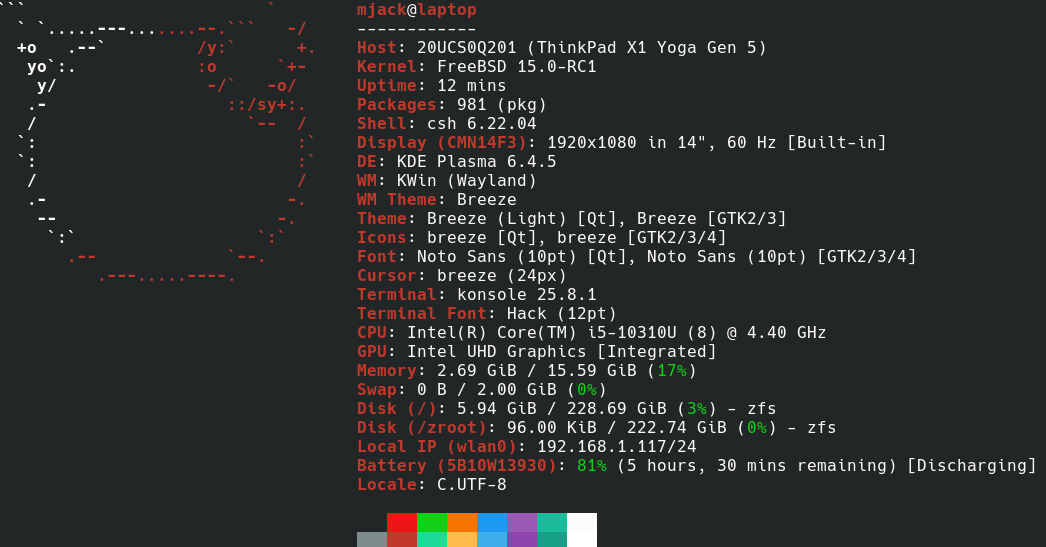

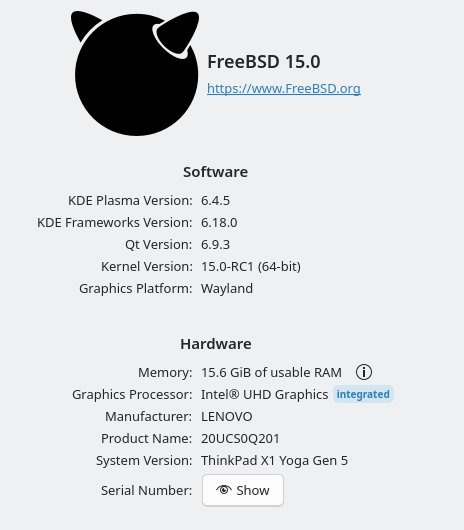

Il foglio di stile per questa istanza l'ho fatto modificando il foglio di stile originale con l'aiuto di alcuni altri esempi e dei bellissimi fogli di stile che trovi linkati più sotto: se ti serve basta che visualizzi il sorgente della pagina e copi tutto quello che sta nel tag style.

Lo puoi includere in una pagina html oppure in un file css.

![[?]](https://snac.tesio.it/giacomo/s/ada2e9f46fca746091009b2baffd00cc.png)

![[?]](https://gts.matteozenatti.net/fileserver/01QA121XK57T8NQC4WP9N1WKXN/attachment/original/01KAC99PBNQ3D6E34V5S75CZTF.jpeg)